ARKit、深度情報、物体認識、そこに現れる世界

ARKit と深度情報が組み合わされると Kinect や HoloLens のような体験が可能になる。

では、そこに物体認識ができるようになったらどうなるだろう。

その前に物体を認識するとは何か

iOS では過去にプライベート API の OpenCL を使用した顔認識がある。

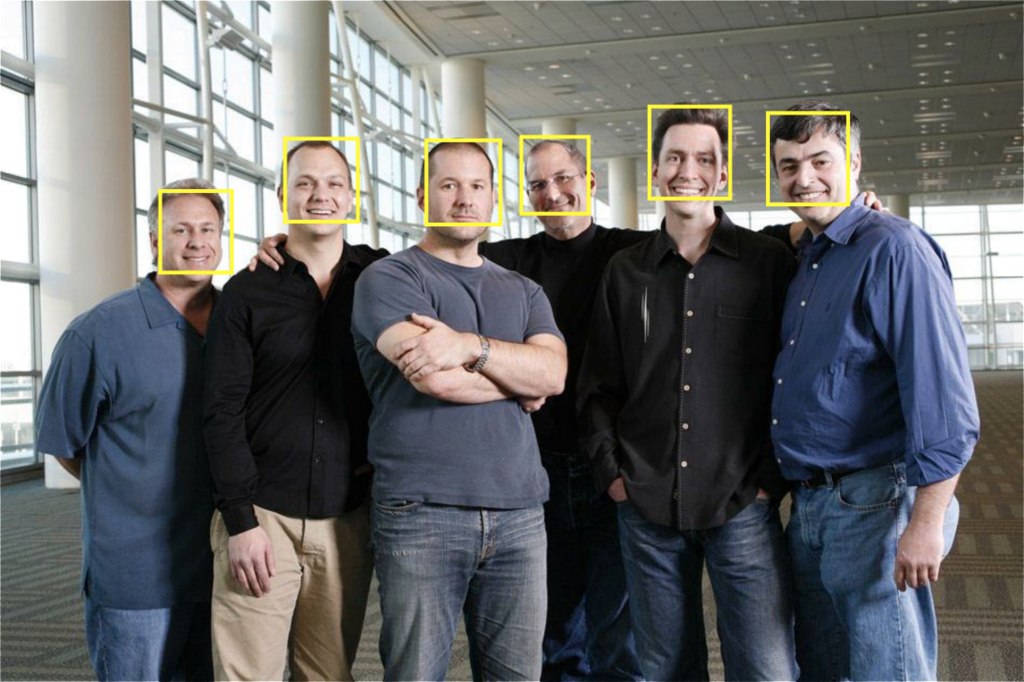

以下の写真のような感じでかを認識できる。

また、写真アプリでカテゴリごとに分類されるのも、画像から物体が何かを認識して行なっているようだ。

例えば、ピープルというカテゴリー分けがされている。

iOS 11 から Vision framework や Core ML で開発者からも簡単にアクセスできる。

(Core ML は学習データがいるので簡単ではないが)

物体認識ができるとどうなるか

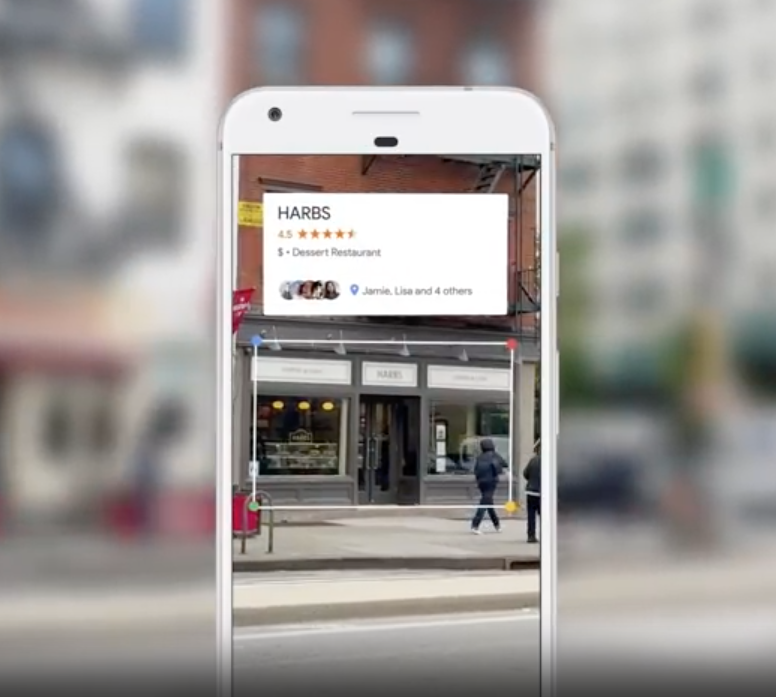

簡単に AR での物体認識が何かと言うと Google Lens であるし、 Microsoft の Story Rimix のように動きに対してなんらかの加工をすることも可能だろう。

まとめるとこのような感じである。

- 物体を文字情報として変換

- 物体の形状や情報の収集

- 収集した情報からの物体作成

- 物体の類似性の調査

- 物体が今後どうなるかの予測

物体を文字情報として変換ということは世界に字幕がつけられるということであり、 機械学習をもとにすれば物体が今後どうなるかの予測ができる。

物体を認識できるということは物体をデジタル的にコピーできることであり、 外で見かけた猫の情報を端末からスキャンできれば、デジタル内ではあるが自分の家で飼うことができるかものしれない。

また、深度情報も含め空間を把握できるということを考えると、 空間においてのアクセシビリティの機能が必要な方に最も有用になるのではと考えている。

その先

多分、Apple が AR メガネを出すのなら、バッテリー持ち等などを考えると、

watchOS のようなものを使用し Apple Watch や Google Glass のような情報を表示するものになるだろう。

ただ、Apple Watch で 2D・3DCG ライブラリの SpriteKit や SceneKit が使用できるようになったことを考えると、

いずれは電脳メガネのようなものを出すのではないだろうかと思っている。